Aunque todo este campo de la informática es innovador en algunos aspectos, tiene antecedentes en los años 40 del siglo XX. En 1943, el neurobiólogo Warren McCulloch y el estadístico Walter Pitss, publicaron un artículo que definía que los eventos neuronales y las relaciones entre ellos pueden tratarse mediante la lógica proposicional. De esta manera se conforma la base y el inicio del desarrollo de la IA tal y como hoy la concebimos.

Pero no fue hasta una década más tarde, en 1956, cuando se celebró la primera Conferencia de Inteligencia Artificial en Darmouth que es considerada como la primera referencia seria a las redes neuronales artificiales. En esta conferencia se presentó la lógica teórica (Minsky, McCarthy, Rochester y Shannon) que es considerado el primer programa informático para solucionar problemas de búsqueda heurística.

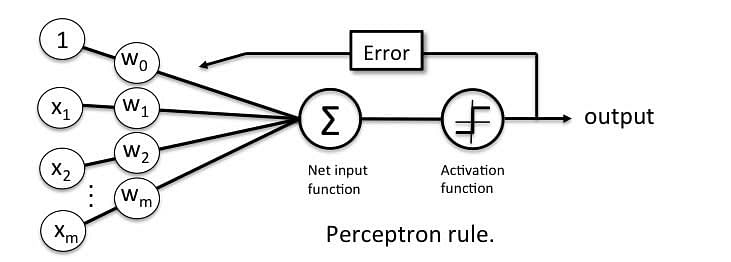

En 1957 se presentó «Perceptron» el primer sistema capaz de identificar patrones geométricos, y en 1959 «Adaline» (Adaptive Linear Neuron) que fue utilizada con diferentes aplicaciones como reconocimiento de voz y caracteres, predicción del tiempo, y en el desarrollo de filtros para eliminar ecos de las líneas telefónicas.

A partir de estos trabajos la comunidad científica tuvo una percepción muy optimista de lo que la IA podría ofrecer, pero a mediados de la década de los 60 se comenzaron a publicar estudios críticos sobre la falta de aplicabilidad de la computación neuronal. Durante los años 70 y 80 pocos investigadores continuaron con esta línea de desarrollo científico (James Anderson, Teuvo Kohonen o Stephen Grossberg).

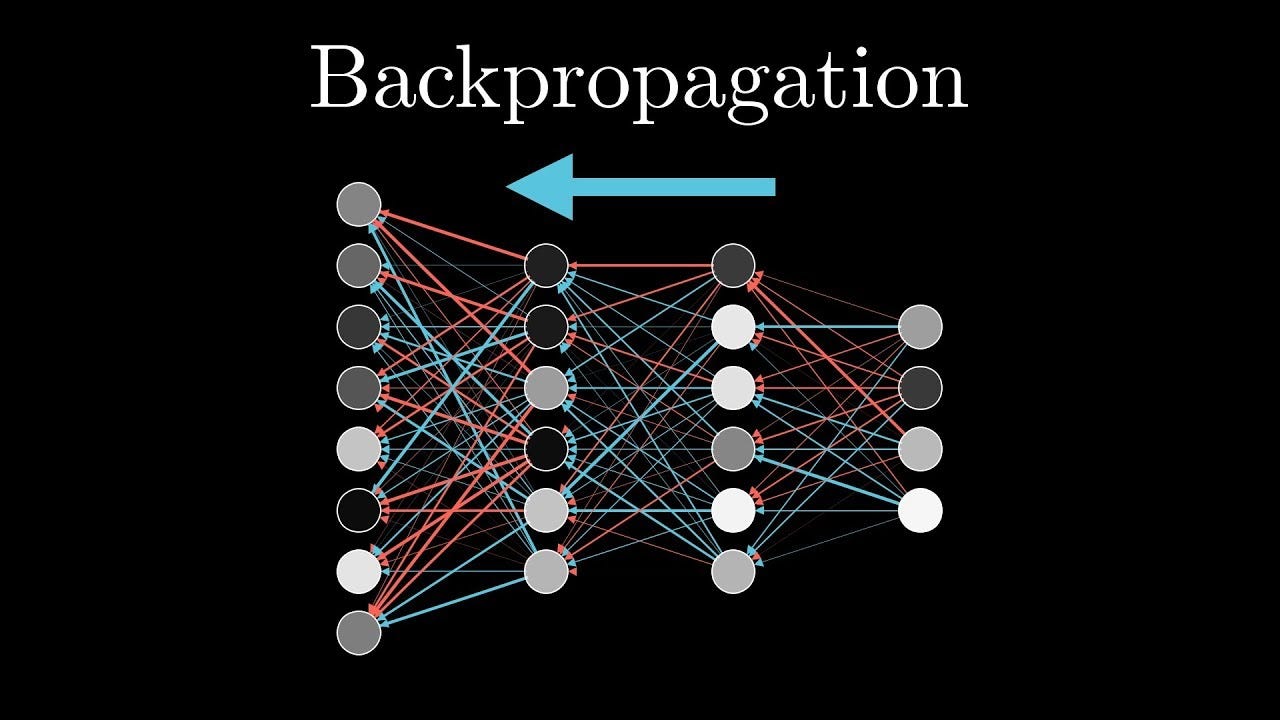

En 1982 John Hopfield crea el algoritmo Backpropagation que presenta un sistema neuronal formado por elementos procesadores interconectados que tienden a un mínimo de energía. Este hecho supuso volver a confiar en las posibilidades de la IA que en las últimas décadas ha tenido un avance exponencial.

Comentarios

Publicar un comentario